Hoe u uw eerste AI-datadiefstal kunt voorkomen

Ontdek waarom het brede gebruik van gen AI copiloten onvermijdelijk zal leiden tot meer datalekken

Dit scenario wordt steeds vaker voorkomend in het tijdperk van gen AI: een concurrent krijgt op de een of andere manier toegang tot gevoelige accountinformatie en gebruikt die gegevens om de klanten van de organisatie te targeten met advertentiecampagnes.

De organisatie had geen idee hoe de gegevens werden verkregen. Het was een nachtmerrie op het gebied van beveiliging die het vertrouwen en de zekerheid van hun klanten in gevaar zou kunnen brengen.

Het bedrijf identificeerde de bron van het datalek: een voormalige werknemer gebruikte een gen AI copilot om toegang te krijgen tot een interne database vol accountgegevens. Ze kopieerden gevoelige details, zoals klantuitgaven en gekochte producten, en namen deze mee naar een concurrent.

Dit voorbeeld benadrukt een groeiend probleem: het brede gebruik van gen AI copiloten zal onvermijdelijk leiden tot meer datalekken.

Volgens een recent onderzoek van Gartner zijn de meest voorkomende toepassingen van AI generatieve AI-gebaseerde applicaties, zoals Microsoft 365 Copilot en Salesforce’s Einstein Copilot. Hoewel deze tools een uitstekende manier zijn voor organisaties om de productiviteit te verhogen, brengen ze ook aanzienlijke gegevensbeveiligingsuitdagingen met zich mee.

In dit artikel zullen we deze uitdagingen verkennen en laten zien hoe je je gegevens kunt beveiligen in het tijdperk van gen AI.

Het gegevensrisico van Gen AI

Bijna 99% van de toestemmingen wordt niet gebruikt en meer dan de helft van die toestemmingen brengt een hoog risico met zich mee. Ongebruikt en te permissief gegevenstoegang is altijd een probleem voor gegevensbeveiliging, maar gen AI gooit olie op het vuur.

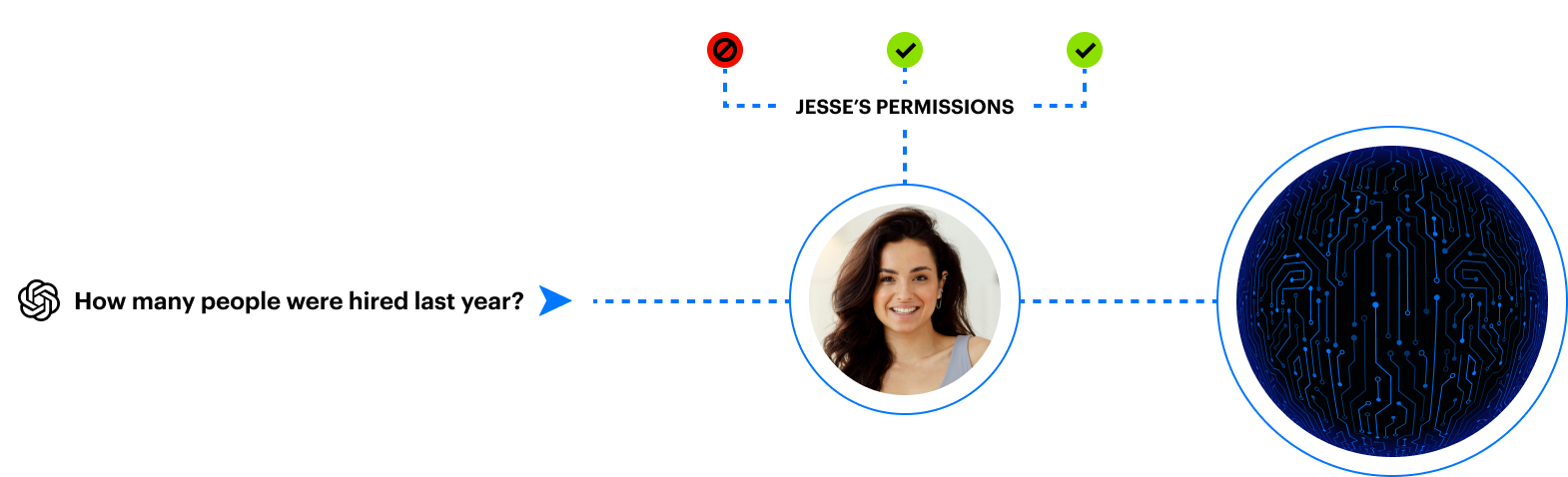

Wanneer een gebruiker een gen AI copilot een vraag stelt, formuleert de tool een natuurlijk taalantwoord op basis van internet- en bedrijfsinhoud via graftechnologie.

Omdat gebruikers vaak te veel permissieve gegevens hebben, kan de copilot eenvoudig gevoelige gegevens laten zien — zelfs als de gebruiker zich niet realiseerde dat ze er toegang toe hadden.

Veel organisaties weten niet eens welke gevoelige gegevens ze hebben, en het juist afstemmen van toegang is bijna onmogelijk om handmatig te doen.

Gen AI verlaagt de drempel voor datalekken

Kwaadwillenden hoeven niet langer te weten hoe ze een systeem moeten hacken of de ins en outs van je omgeving te begrijpen. Ze kunnen gewoon een copilot om gevoelige informatie of inloggegevens vragen die hen in staat stellen om lateraal te bewegen.

Beveiligingsuitdagingen die gepaard gaan met het inschakelen van gen AI-tools omvatten:

- Medewerkers hebben toegang tot veel te veel gegevens

- Gevoelige gegevens zijn vaak niet gelabeld of verkeerd gelabeld

- Insiders kunnen snel gegevens vinden en exfiltreren met behulp van natuurlijke taal

- Aanvallers kunnen geheimen ontdekken voor privilege-escalatie en laterale beweging

- Het juiste afstemmen van toegang is onmogelijk om handmatig te doen

- Generatieve AI kan snel nieuwe gevoelige gegevens creëren

Deze data security uitdagingen zijn niet nieuw, maar ze zijn zeer uitbuitbaar, gezien de snelheid en het gemak waarmee gen AI informatie naar boven haalt.

Hoe u uw eerste AI-inbreuk kunt stoppen

De eerste stap in het wegnemen van de risico’s die gepaard gaan met gen AI is ervoor te zorgen dat je zaakjes op orde zijn.

Het is een slecht idee om copiloten los te laten in je organisatie als je niet zeker weet waar je gevoelige gegevens hebt, wat die gevoelige gegevens zijn, de blootstelling en risico’s niet kunt analyseren, en de beveiligingslekken en foutieve configuraties niet efficiënt kunt verhelpen.

Zodra je grip hebt op gegevensbeveiliging in je omgeving en de juiste processen op hun plaats zijn, ben je klaar om een copilot uit te rollen.

Op dit punt moet je je concentreren op toestemmingen, labels en menselijke activiteit.

- Toestemmingen: Zorg ervoor dat de toestemmingen van je gebruikers correct zijn afgestemd en dat de toegang van de copilot deze toestemmingen weerspiegelt.

- Labels: Zodra je begrijpt welke gevoelige gegevens je hebt en wat die gevoelige gegevens zijn, kun je er labels op aanbrengen om DLP af te dwingen.

- Menselijke activiteit: Het is essentieel om te monitoren hoe medewerkers de copilot gebruiken en verdachte gedragingen te bekijken die worden gedetecteerd. Het monitoren van prompts en bestanden die gebruikers openen is cruciaal om uitgebuite copiloten te voorkomen.

Het integreren van deze drie gegevensbeveiligingsgebieden is niet eenvoudig en kan niet alleen met handmatige inspanningen worden bereikt. Weinig organisaties kunnen gen AI copiloten veilig adopteren zonder een holistische benadering van gegevensbeveiliging en specifieke controles voor de copiloten zelf.

Voorkom AI-inbreuken met Varonis

Varonis helpt klanten wereldwijd om te beschermen wat het belangrijkst is: hun gegevens. We hebben onze diepgaande expertise toegepast om organisaties te beschermen die van plan zijn om generatieve AI te implementeren.

Als je net begint aan je gen AI-reis, is de beste manier om te beginnen met onze gratis Data Risk Assessment. In minder dan 24 uur heb je een realtime overzicht van je risicogegevens om te bepalen of je veilig een gen AI copilot kunt adopteren.

Om meer te weten te komen, verken onze AI-beveiligingsbronnen.

Gesponsord en geschreven door Varonis.

Opzoek naar de laatste updates uit onze securitylog?

Inhoud mede mogelijk gemaakt door OpenAI.